O ChatGPT é um grande modelo de linguagem. Foi desenvolvido um modelo menor de alto desempenho, que funciona melhor em celulares.

Fonte: TechXplore (Traduzido para o Português)

Grandes modelos de linguagem (GML), como a renomada plataforma ChatGPT da Open AI, se tornaram cada vez mais difundidos, com muitos usuários de internet contando com eles para encontrar informações rapidamente e produzir textos para vários propósitos. No entanto, a maioria destes modelos tem um desempenho muito melhor em computadores, devido às altas demandas computacionais associadas com o tamanho e a capacidade de processamento de dados.

Para enfrentar este desafio, cientistas da computação desenvolveram pequenos modelos de linguagem (PML), que possuem uma arquitetura similar, mas são menores em tamanho. Estes modelos poderiam ser usados com mais facilidade em smartphones, permitindo a usuários consultarem plataformas estilo ChatGPT mais facilmente.

Pesquisadores da Universidade de Correios e Telecomunicações de Beijing (BUPT) introduziram recentemente o PhoneLM, uma nova arquitetura de PML para smartphones, que pode ser eficiente e de alto desempenho. A arquitetura proposta, apresentada em um artigo no servidor de pré-impressão arXiv, foi projetada para obter eficiência quase ótima de tempo de execução, antes de passar por um pré-treinamento em dados de texto.

“O objetivo do nosso recente projeto era explorar o espaço de projeto do GML para a implantação de recursos com eficiência em dispositivos móveis.” disse à TechXplore, Mangwei Xu, autor sênior do artigo.

“Anteriormente, o desenvolvimento do GML seguia o trajeto de primeiro projetar e pretreinar o GML para boa capacidade e então, otimizá-lo na fase de pós-treinamento, ou seja, quantização e poda. Nossos experimentos, por outro lado, indicam que as configurações do GML (largura e profundidade) possuem mais impactos na eficiência do tempo de execução, do que a capacidade.”

O modelo introduzido por Xu e seus colegas foi construído em um princípio de projeto inovador que prioriza eficiência. Em contraste com outros PML existentes, o PhoneLM depende da busca de arquitetura antes do pré-treinamento, que envolve pesquisar por uma arquitetura que funciona mais eficientemente no hardware onde a arquitetura será implementada antes da fase de pré-treinamento.

“O PhoneLM segue a arquitetura padrão de GML”, disse Xu. “O que é único, é a forma como foi projetada: nós procuramos os hiperparâmetros da arquitetura (largura, profundidade, etc.) em um hardware (no caso, o smartphone), escolhemos as configurações com a maior velocidade de inferência e pretreinamos com dados de alta qualidade.”

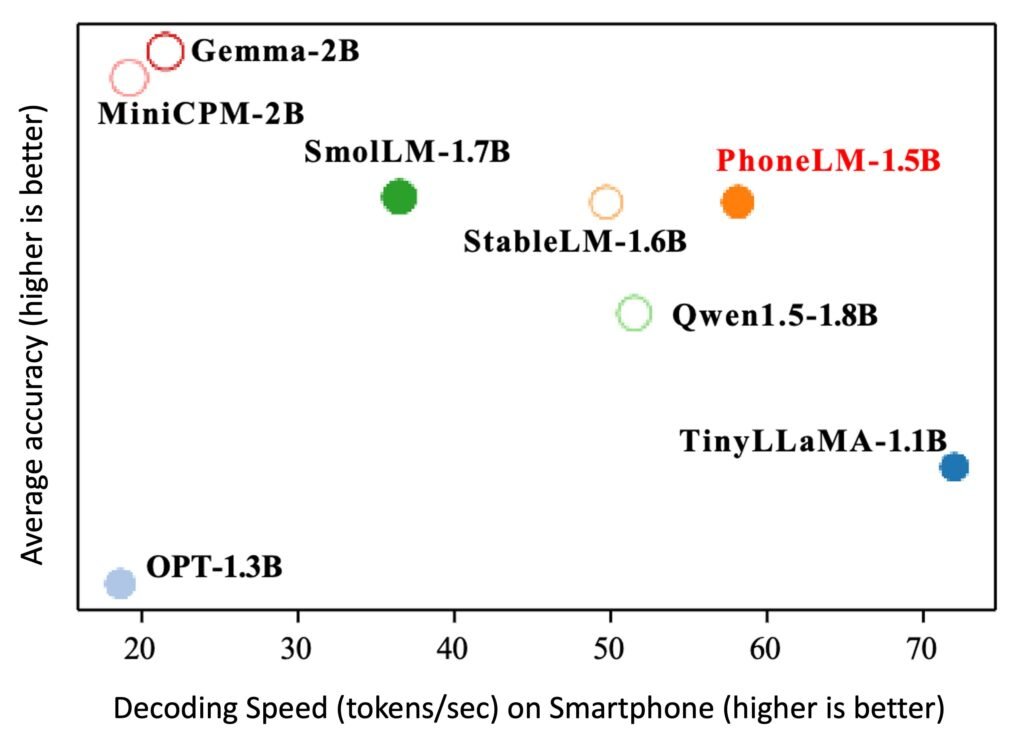

Nos testes iniciais em smartphones, o modelo desenvolvido pela equipe teve um desempenho notavelmente bom, rodando extremamente rápido em comparação com outros GMLs com um parâmetro de tamanho semelhante. Notavelmente, este aprimoramento em velocidade não comprometeu significativamente o desempenho, pois o modelo ainda alcançou as capacidades de processamento de linguagem natural de última geração.

Os pesquisadores publicaram o código e a demonstração no Android da versão ajustável do PhoneLM, ambos publicados no Github. O novo modelo de linguagem para smartphone poderá em breve ser aprimorado e testado para facilitar a sua futura implantação em dispositivos móveis comerciais.